Introduksjon

Hei, jeg heter Mathias og jeg jobber med å teste presisjonen til forskjellige eyetracking softwares hos NNL. Dette gjøres i forbindelse med NNLs virtual reality (VR) produkt. VR brukes sammen med fMRI blant annet for å utforske hvilken stimulus forskjellige situasjoner og opplevelser har på hjernen og hvilke områder som opplever stimulus. Ved bruk av eyetracking (ET) blir det mulig å se mye mer nøyaktig hva pasienten ser på som gir hvilken stimulus. På grunn av dette vil ET være et viktig verktøy i forskning på sykdommer og fenomener vi har lite forståelse på, noen eksempler på dette kan være Parkinsons, Alzheimers og fobier. ET kan også brukes som en interaktiv løsning for handlinger og spill i VR.

Videre utvikling

Hos NNL er Arringtons ET-system allerede i bruk, så hvorfor tester jeg nye softwares? Grunnen til dette er at det nåværende systemet ikke funker helt optimalt. For å forbedre dette systemet er vanskelig da det ikke er lagd av NNL og det er veldig lang responstid (opptil måneder) fra Arrington ved problemer. Derfor vil det være veldig gunstig å få en ny software som både fungerer bedre til målene til NNL og som er lettere å optimalisere.

Software-systemet jeg jobber med heter pupil-labs og en en open source ET-prosjekt med all kodespråk i python. Målet mitt er å kunne teste hvor nøyaktig og presis ET-softwaren er når jeg har video hvor personen ser på kjente koordinater. Koden er gitt ut av selskapet Pupil Labs og er siden bygget på av mange deltagere på github. Pupil-labs er laget med hensyn på at brukeren bruker et par briller med ett kamera til hvert øye (eye0 / eye1) og et til verden rundt (world-cam), på denne måten kan man se hvor i verdenen personen ser som en liten sirkel i world-cam. Jeg må tilpasse koden slik at world-cam ikke er et kamera men en pc/tv-skjerm. Pupil-labs bruker også live-streaming fra kameraer i bruk, jeg ønsker å bruke videoer og ikke live-streaming for å nå målet. Derfor har mye arbeid i starten gått på å endre kode og tilpasse slik at videofiler kan brukes.

Nå er jeg på det tidspunktet at kalibrering er det siste som trengs før jeg kan få nyttig informasjon om pupil-labs-softwaren. Problemet er at kalibreringen til pupil-labs vanligvis foregår slik at brukeren får live beskjed om hvilke kjente punkter de skal se på, også tilpasser den seg etter posisjonen til pupillen for å beregne for alle mulige punkter. Jeg må få pupil-labs til å bruke de samme kalibreringspunktene som er brukt i en kjent video og sync-e streamingen slik at pupillene er på riktig posisjon til riktig tid.

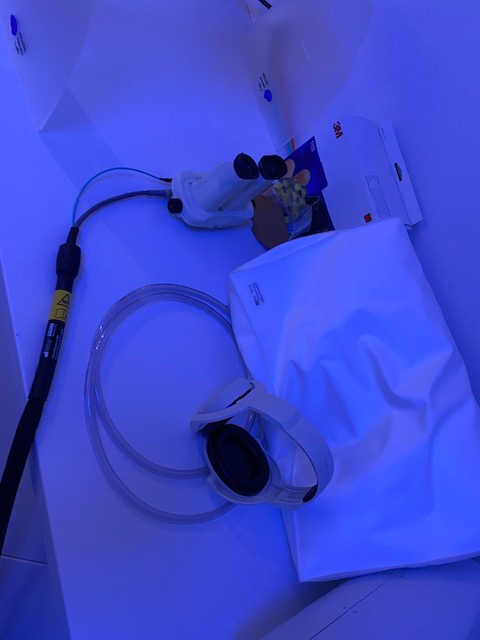

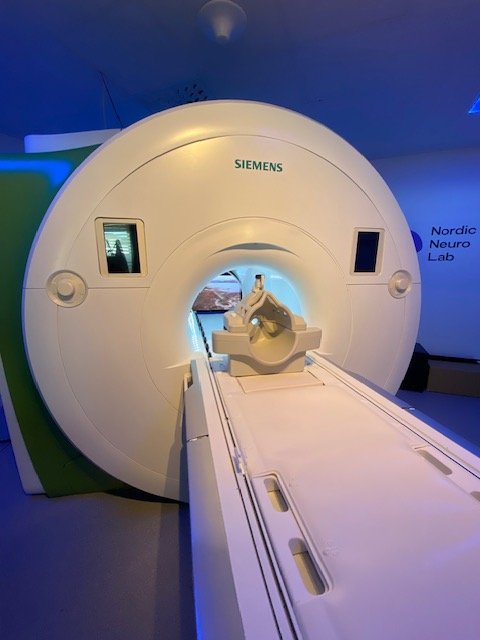

Det har vært et spennende prosjekt så langt og jeg har lært mye om ET, hvordan maskinlæring brukes i ET og mange nye måter å kode og funksjoner i python. Bildene viser VR-brillene med innebygget øye kameraer og et headsett som bruker luft (altså bare et tomt rør) for å transportere lyd til brukeren i MR-maskinen. I tillegg vises simulerings MR-maskinen og TV-skjermen som kan tilkobles.